⏶5

鲁棒多模态大语言模型抵抗模态冲突

发表

由  Zongmeng Zhang 提交

Zongmeng Zhang 提交

作者:  Zongmeng Zhang, Wengang Zhou, Jie Zhao, Houqiang Li

Zongmeng Zhang, Wengang Zhou, Jie Zhao, Houqiang Li

摘要

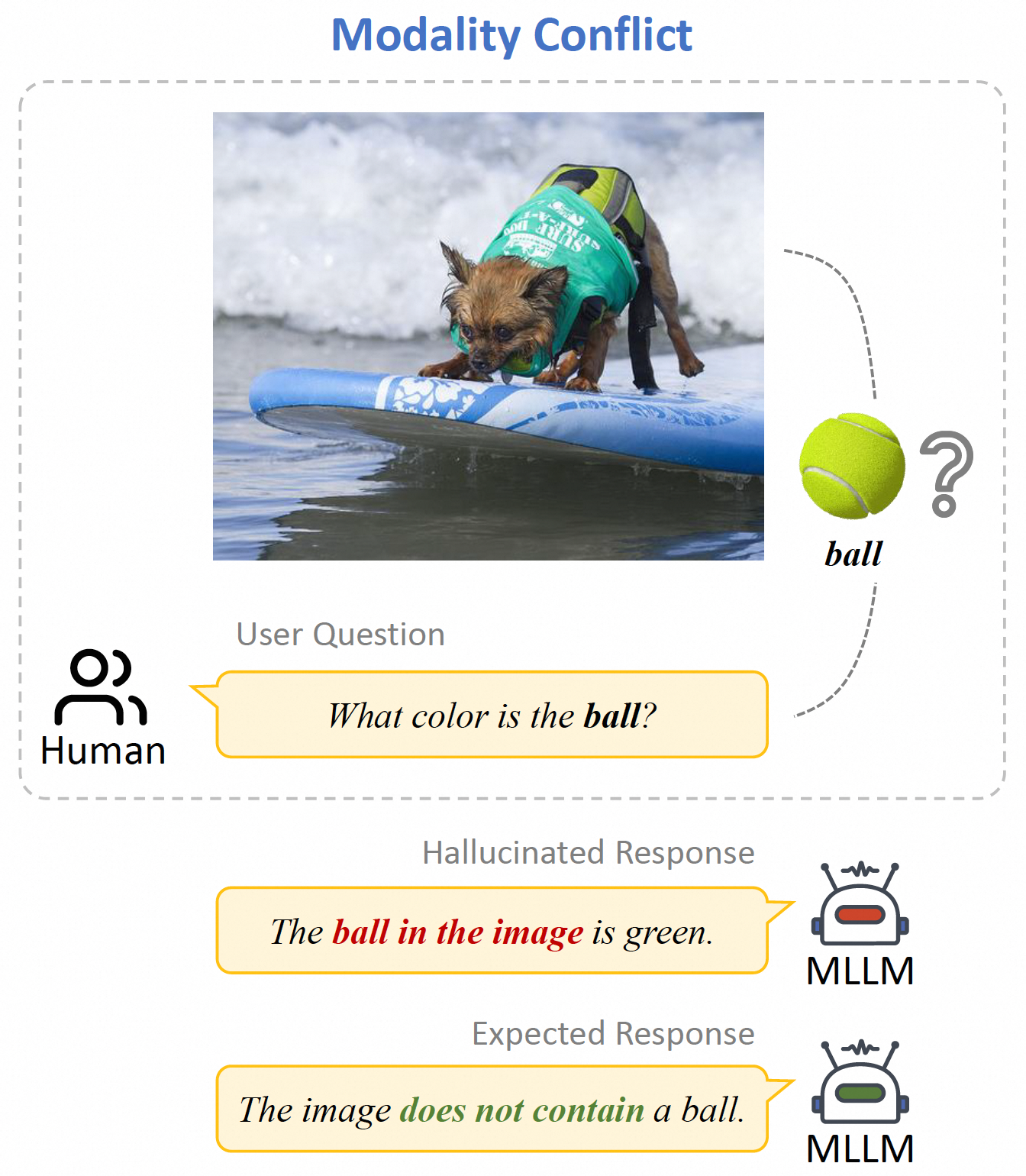

尽管多模态大型语言模型(MLLM)在视觉-语言任务中表现出令人印象深刻的能力,但它们在现实世界场景中容易产生幻觉。本文从模态冲突的角度研究了MLLM中的幻觉现象。与现有工作侧重于模型响应与输入之间的冲突不同,我们研究了来自不同模态的输入中固有的冲突,这些冲突使MLLM陷入两难境地,并直接导致幻觉。我们正式定义了模态冲突,并构建了一个名为多模态模态冲突(MMMC)的数据集,以模拟视觉-语言任务中的这种现象。本文提出了三种基于提示工程、有监督微调和强化学习的方法,以缓解模态冲突引起的幻觉。在MMMC数据集上进行了大量实验,以分析这些方法的优缺点。我们的结果表明,强化学习方法在缓解模态冲突下的幻觉方面取得了最佳性能,而有监督微调方法表现出有前景且稳定的性能。我们的工作揭示了导致幻觉的未被注意到的模态冲突,并为MLLM的鲁棒性提供了更多见解。

评论

论文作者

论文提交者

ICML 2025

对抗模态冲突的鲁棒多模态大语言模型