⏶12

通过强化学习实现的大型语言模型交错推理

发表

由  Roy 提交

Roy 提交

作者:  Roy Xie, David Qiu,

Roy Xie, David Qiu,  Deepak Gopinath, Dong Lin,

Deepak Gopinath, Dong Lin,  Yanchao Sun, Chong Wang,

Yanchao Sun, Chong Wang,  Saloni Potdar, Bhuwan Dhingra

Saloni Potdar, Bhuwan Dhingra

摘要

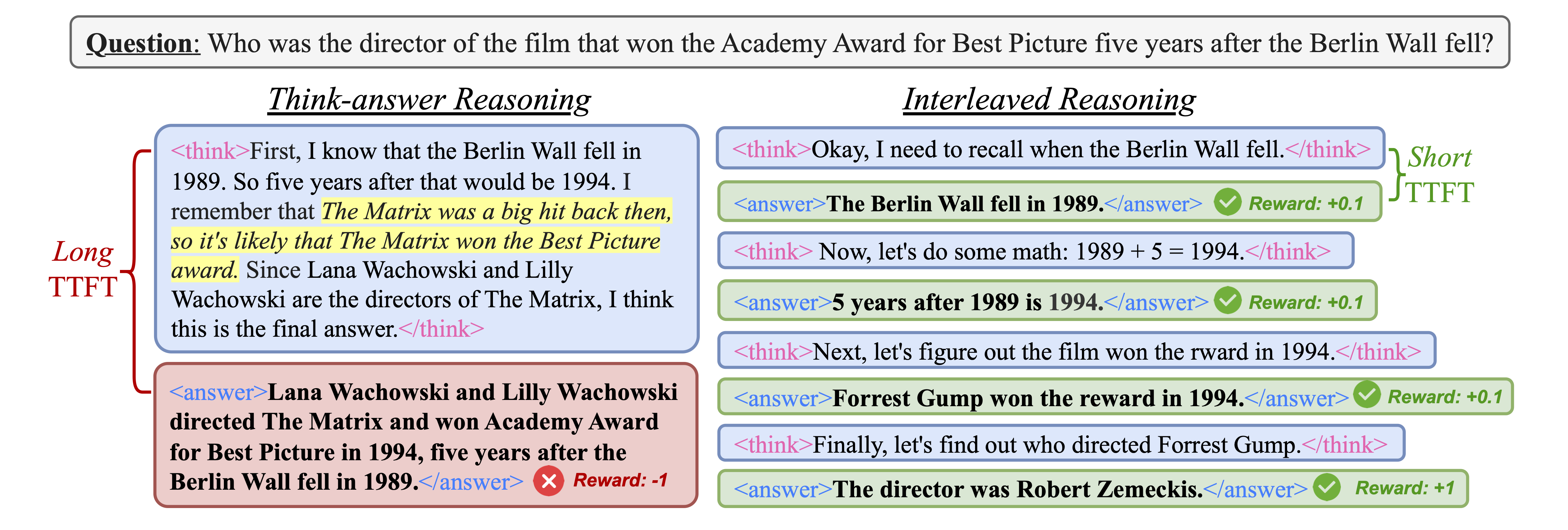

长链式思考(CoT)显著增强了大语言模型(LLM)的推理能力。然而,冗长的推理轨迹会导致效率低下并增加首个 token 的生成时间(TTFT)。我们提出了一种新颖的训练范式,利用强化学习(RL)来引导推理型 LLM 在处理多跳问题时交替进行思考和回答。我们观察到模型本身具备执行交替推理的能力,这可以通过 RL 进一步增强。我们引入了一种简单而有效的基于规则的奖励机制,以激励正确的中间步骤,通过利用交替推理过程中产生的中间信号,引导策略模型走向正确的推理路径。在五个不同数据集和三种 RL 算法(PPO、GRPO 和 REINFORCE++)上进行的广泛实验表明,与传统的“思考-回答”推理相比,我们的方法持续改进,且无需外部工具。具体而言,我们的方法平均减少了超过 80% 的 TTFT,并将 Pass@1 准确率提高了高达 19.3%。此外,我们的方法仅在问答和逻辑推理数据集上进行训练,却对 MATH、GPQA 和 MMLU 等复杂推理数据集表现出强大的泛化能力。此外,我们进行了深入分析,揭示了关于条件奖励建模的几个有价值的见解。

评论

论文作者

论文提交者