⏶16

Seq vs Seq:一个开放的配对编码器和解码器套件

发表

由  Antoine Chaffin 提交

Antoine Chaffin 提交

作者: Orion Weller, Kathryn Ricci,  Marc Marone,

Marc Marone,  Antoine Chaffin, Dawn Lawrie, Benjamin Van Durme

Antoine Chaffin, Dawn Lawrie, Benjamin Van Durme

摘要

大型语言模型(LLM)社区几乎完全专注于纯解码器(decoder-only)语言模型,因为它们更易于用于文本生成。然而,社区中仍有很大一部分人使用纯编码器(encoder-only)模型来完成分类或检索等任务。此前的研究曾试图比较这些架构,但被迫在参数数量、训练技术和数据集都不同的模型之间进行比较。我们推出了 SOTA 级别的开放数据 Ettin 模型套件:这是一系列配对的纯编码器和纯解码器模型,参数量从 1700 万到 10 亿不等,训练数据量高达 2 万亿个 token。对纯编码器和纯解码器模型使用相同的训练方案,在各自的规模上都产生了 SOTA 级别的结果,作为编码器击败了 ModernBERT,作为解码器击败了 Llama 3.2 和 SmolLM2。与之前的研究一样,我们发现纯编码器模型在分类和检索任务上表现出色,而解码器在生成任务上表现出色。然而,我们表明,通过继续训练将解码器模型适配到编码器任务(反之亦然),其效果要逊于直接使用针对相反目标的模型(例如,一个 4 亿参数的编码器在 MNLI 任务上的表现优于一个 10 亿参数的解码器,而在生成任务上则情况相反)。我们开源了本研究的所有成果,包括训练数据、按检查点分段的训练顺序以及 200 多个检查点,以便未来的研究能够分析或扩展训练的各个方面。

评论

非常感谢 @orionweller!

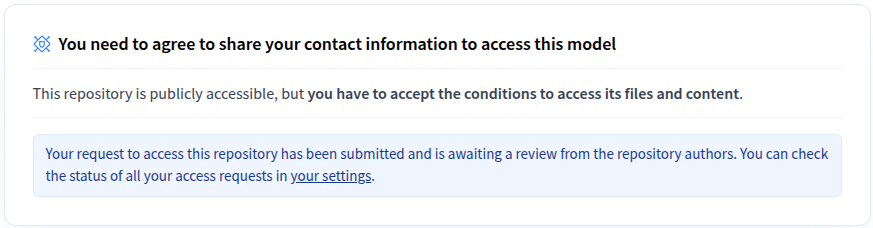

我已经能够访问该模型,并且也应用了与ModernBERT相同/需要的tokenizer修复。

使用ModernBERT,我在开发集上获得了96.32 ± 0.15的成绩(经过少量超参数搜索后5次运行的平均值),Ettin 400M显示为96.17 ± 0.10。BERT Base报告的成绩是96.40(取自原始论文的表7)。在测试集方面:ModernBERT为92.23 ± 0.16,Ettin为92.07 ± 0.21,而BERT Base报告的成绩是92.40。

更多信息请参阅我的GitHub仓库。

(是的,BERT使用了文档级特征,但它也只在约16GB的数据上进行了预训练;))。

不幸的是,关于token分类的结果缺失,但别担心,我很快就会运行它们 😅