⏶58

迈向具有深度推理能力的智能体RAG:LLM中RAG-推理系统综述

发表

由  Weizhi Zhang 提交

Weizhi Zhang 提交

作者: Yangning Li,  Weizhi Zhang, Yuyao Yang, Wei-Chieh Huang, Yaozu Wu, Junyu Luo, Yuanchen Bei,

Weizhi Zhang, Yuyao Yang, Wei-Chieh Huang, Yaozu Wu, Junyu Luo, Yuanchen Bei,  Henry Peng Zou, Xiao Luo, Yusheng Zhao, Chunkit Chan, Yankai Chen, Zhongfen Deng, Yinghui Li, Hai-Tao Zheng, Dongyuan Li, Renhe Jiang, Ming Zhang, Yangqiu Song, Philip S. Yu

Henry Peng Zou, Xiao Luo, Yusheng Zhao, Chunkit Chan, Yankai Chen, Zhongfen Deng, Yinghui Li, Hai-Tao Zheng, Dongyuan Li, Renhe Jiang, Ming Zhang, Yangqiu Song, Philip S. Yu

摘要

检索增强生成(RAG)通过注入外部知识提升了大语言模型(LLM)的事实性,但在需要多步推理的问题上表现不佳;相反,纯粹以推理为导向的方法常常产生幻觉或事实基础错误。本综述从一个统一的推理-检索视角综合了这两个研究方向。我们首先梳理了高级推理如何优化 RAG 的各个阶段(推理增强的 RAG)。然后,我们展示了不同类型的检索知识如何为复杂推理补充缺失的前提并扩展上下文(RAG 增强的推理)。最后,我们重点介绍了新兴的协同式 RAG-推理框架,其中(智能体)大语言模型迭代地交织搜索和推理,从而在知识密集型基准测试中取得了最先进的性能。我们对相关方法、数据集和开放性挑战进行了分类,并为构建更有效、多模态自适应、可信赖和以人为中心的更深层次 RAG-推理系统勾画了研究途径。相关资源收录于 https://github.com/DavidZWZ/Awesome-RAG-Reasoning。

评论

论文作者

论文提交者

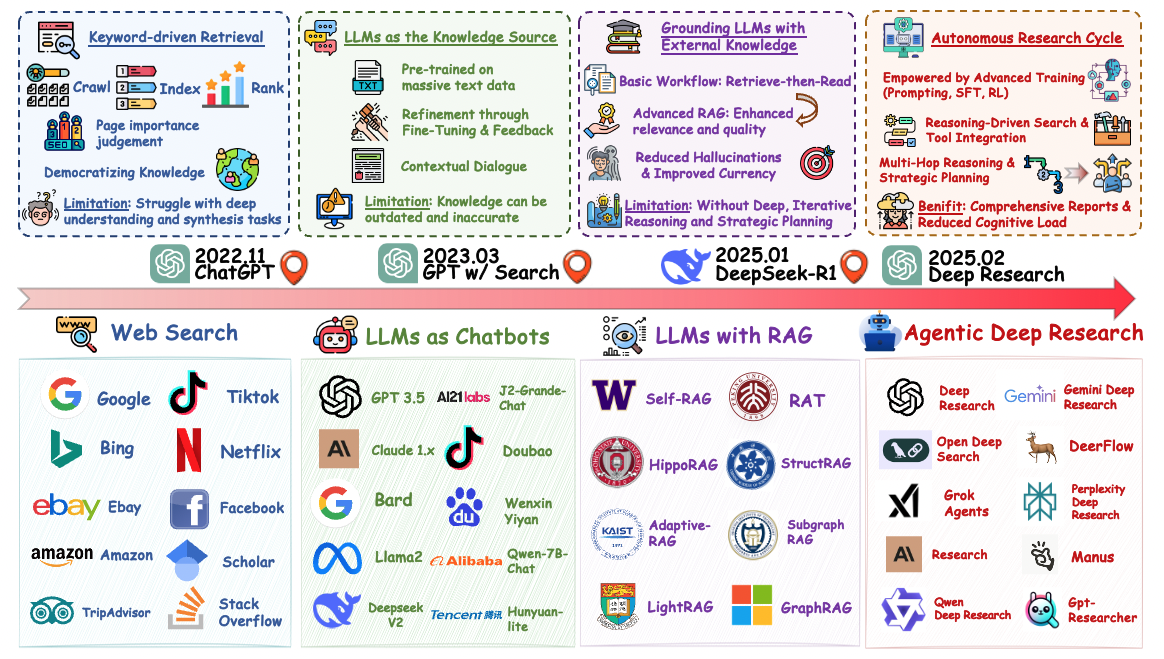

🤖 作为一项更侧重于智能体的扩展,我们强调信息搜索的范式转变——从传统的网页搜索转向智能体深度研究,其中自主智能体迭代地搜索、推理和综合信息以应对复杂任务。

📄 论文:https://arxiv.org/abs/2506.18959

📚 GitHub:https://github.com/DavidZWZ/Awesome-Deep-Research

尽管二者都能增强大型语言模型(LLMs),🔍 朴素RAG 和 🧠 纯粹推理在历史上却在不同社区中独立发展,各自拥有独特的基线和相应的局限性。我们的综述,以及配套的GitHub仓库,通过为研究人员和从业者汇编包括论文、数据集和开源实现等重要资源,弥合了这两个领域之间的鸿沟。🚀 🚀 🚀

🔥 🔥 🔥 GitHub仓库地址:https://github.com/DavidZWZ/Awesome-RAG-Reasoning。