⏶3

FEAT:用于医学视频生成的全维度高效注意力Transformer

发表

由  Zhang Ruichong 提交

Zhang Ruichong 提交

作者:  Huihan Wang,

Huihan Wang,  Zhiwen Yang, Hui Zhang, Dan Zhao, Bingzheng Wei, Yan Xu

Zhiwen Yang, Hui Zhang, Dan Zhao, Bingzheng Wei, Yan Xu

摘要

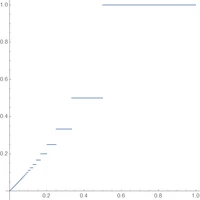

高质量动态医学视频的合成仍然是一个重大挑战,因为它需要对空间一致性和时间动态进行建模。现有的基于 Transformer 的方法面临关键限制,包括通道交互不足、自注意力带来的高计算复杂性,以及在处理不同噪声水平时来自时间步长嵌入的粗糙去噪指导。在这项工作中,我们提出了 FEAT,一种全维度高效注意力 Transformer,通过三项关键创新来解决这些问题:(1) 一个统一范式,采用顺序的空间-时间-通道注意力机制来捕获所有维度上的全局依赖性,(2) 针对每个维度中的注意力机制采用线性复杂度设计,利用加权键值注意力和全局通道注意力,以及 (3) 一个残差值引导模块,提供细粒度的像素级引导以适应不同的噪声水平。我们在标准基准和下游任务上评估了 FEAT,结果表明,FEAT-S 仅使用最先进模型 Endora 23% 的参数,却达到了可比甚至更优的性能。此外,FEAT-L 在多个数据集上超越了所有对比方法,展示了卓越的有效性和可扩展性。代码可在 https://github.com/Yaziwel/FEAT 获取。

使用高效线性注意力(例如RWKV)生成医学视频。